近期,人工智能学院肖立特聘研究员在国际顶级期刊《Medical Image Analysis》(中国科学院一区,IF:13.828)发表题目为“Radiology report generation with a learned knowledge base and multi-modal alignment”的研究论文。该文围绕基于胸部X光的放射学报告自动化生成任务,提出了一种自学习知识库和多模态对齐机制指导视觉特征和医学特征的精确学习,肖立老师为论文通讯作者,论文合作者包括IEEE/NAI/AIMBE/MICCAI/IAMBE Fellow,中国科学技术大学生物医学工程学院周少华院长、腾讯医疗AI实验室专家研究员吴贤以及北京清华长庚医院放射科郑卓肇主任。

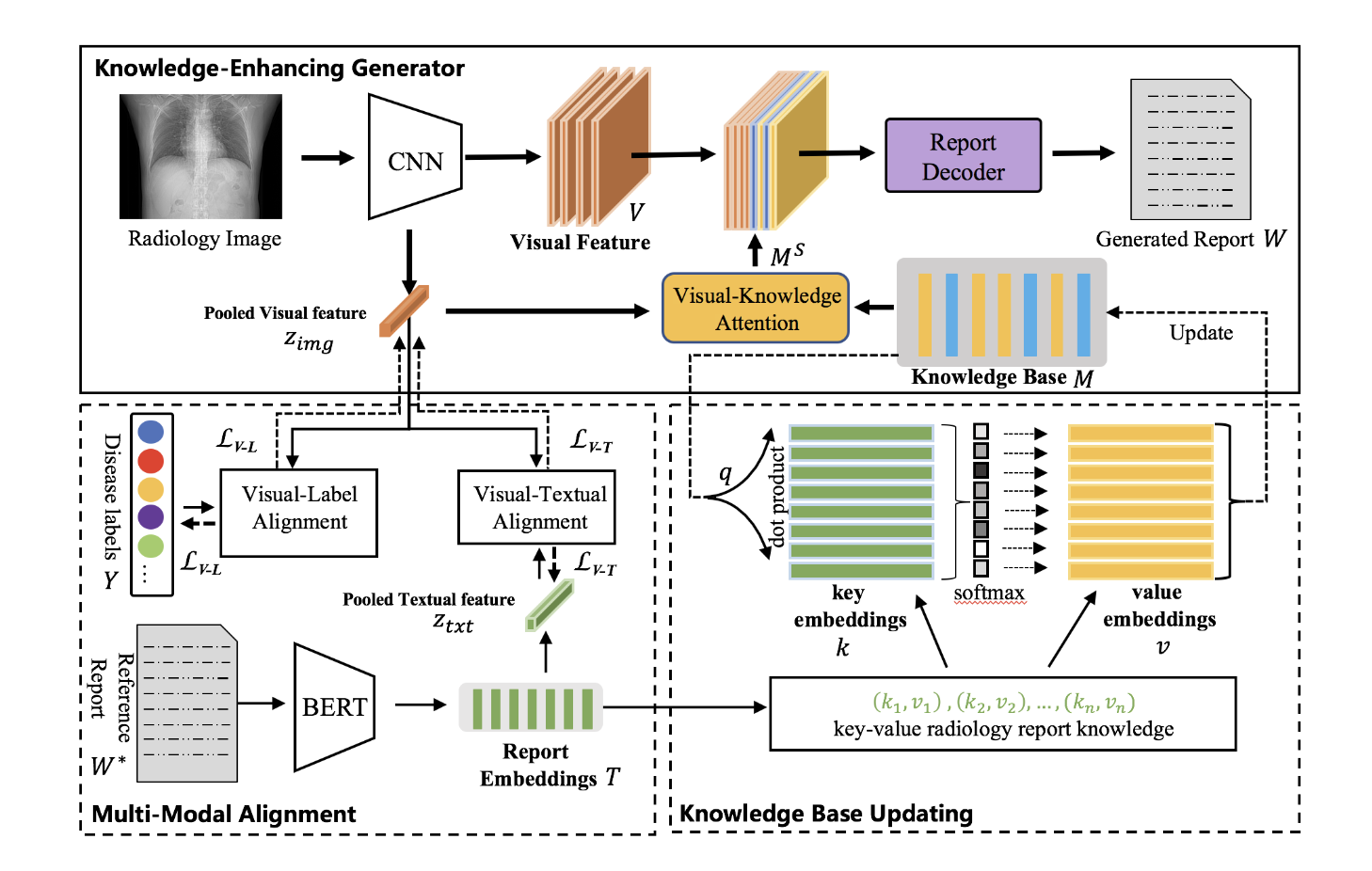

放射学报告对于指导患者的治疗至关重要,而撰写放射学报告对放射科医生来说是一个沉重的负担。本文提出了一种自动化多模态的方式生成胸部X光片诊断报告的方法。该方法的动机是基于作者观察到的放射学报告中的描述与X射线图像的特定信息高度相关,它具有两个不同的模块:(i)自学习知识库:为了储存放射学报告中嵌入的知识,本文建立了一个知识库,可以在不需要人工标注的情况下从文本嵌入中自动提取和释放医学知识;(ii)多模态对齐:为了促进报告、疾病标签和图像之间的语义对齐,本工作利用文本嵌入来指导视觉特征空间的学习。与同类工作相比,该方法无需引入任何额外人工过程和外部知识,可以直接在任何新数据集上训练,泛化性强,精准度高。

该方法在不引入额外人工和计算量的情况下,在IU-Xray和MIMIC-CXR两个公开数据集上的几乎所有评价指标都超过了当前最优模型(State-of-the-art),展现了其便捷性、高效性、精确性和鲁棒性。

肖立老师未来拟将该方法应用到其它医学多模态融合任务,包括跨尺度多模态影像数据的融合及智能诊断,以及其它跨模态生成场景。该工作获得CCF-腾讯犀牛鸟项目资助,肖立老师获得2021年度该项目终期答辩优秀奖。